Durante años, la Inteligencia Artificial fue vista como algo lejano, casi mágico. Robots con emociones, máquinas que piensan, computadoras que vencen humanos… suena a película, ¿no?

Pero la verdad es que la IA tiene una historia larga, llena de momentos clave que nos trajeron hasta este punto, donde ya no es ficción: es herramienta real, cotidiana y cada vez más accesible. Así que aquí te cuento un poco sobre este recorrido y evolución.

1943: Creación de una Red Neuronal

Iniciamos con la publicación del artículo “A Logical Calculus of Ideas Immanent in Nervous Activity” de Warren McCulloch y Walter Pitts, donde se presentaba el primer modelo matemático para la creación de una red neuronal.

1950: El Test de Turing

El matemático Alan Turing publica su ensayo “Computing Machinery and Intelligence”, donde lanza una pregunta que cambiaría la historia: “¿Pueden las máquinas pensar?”

Aquí introduce el Test de Turing, una prueba para evaluar si una máquina puede imitar el pensamiento humano. Fue el punto de partida filosófico y técnico para toda la conversación sobre IA, incluso hasta el día de hoy.

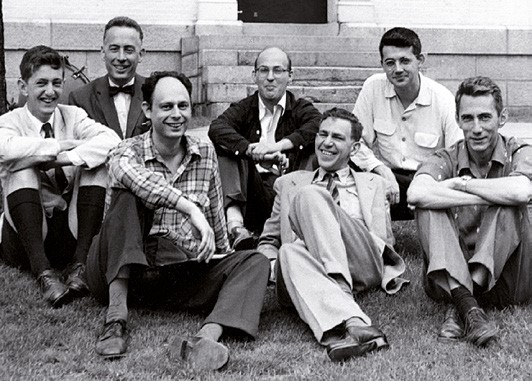

1956: Nace el Término “Inteligencia Artificial”

En el verano de 1956, John McCarthy, Marvin Minsky, Nathaniel Rochester y Claude Shannon organizan la conferencia de Dartmouth, en EE.UU.

Ahí se propone por primera vez el término “Artificial Intelligence”, y se plantea la idea de que una máquina puede simular la inteligencia humana. Este evento se considera oficialmente el “nacimiento” de la IA como campo de estudio.

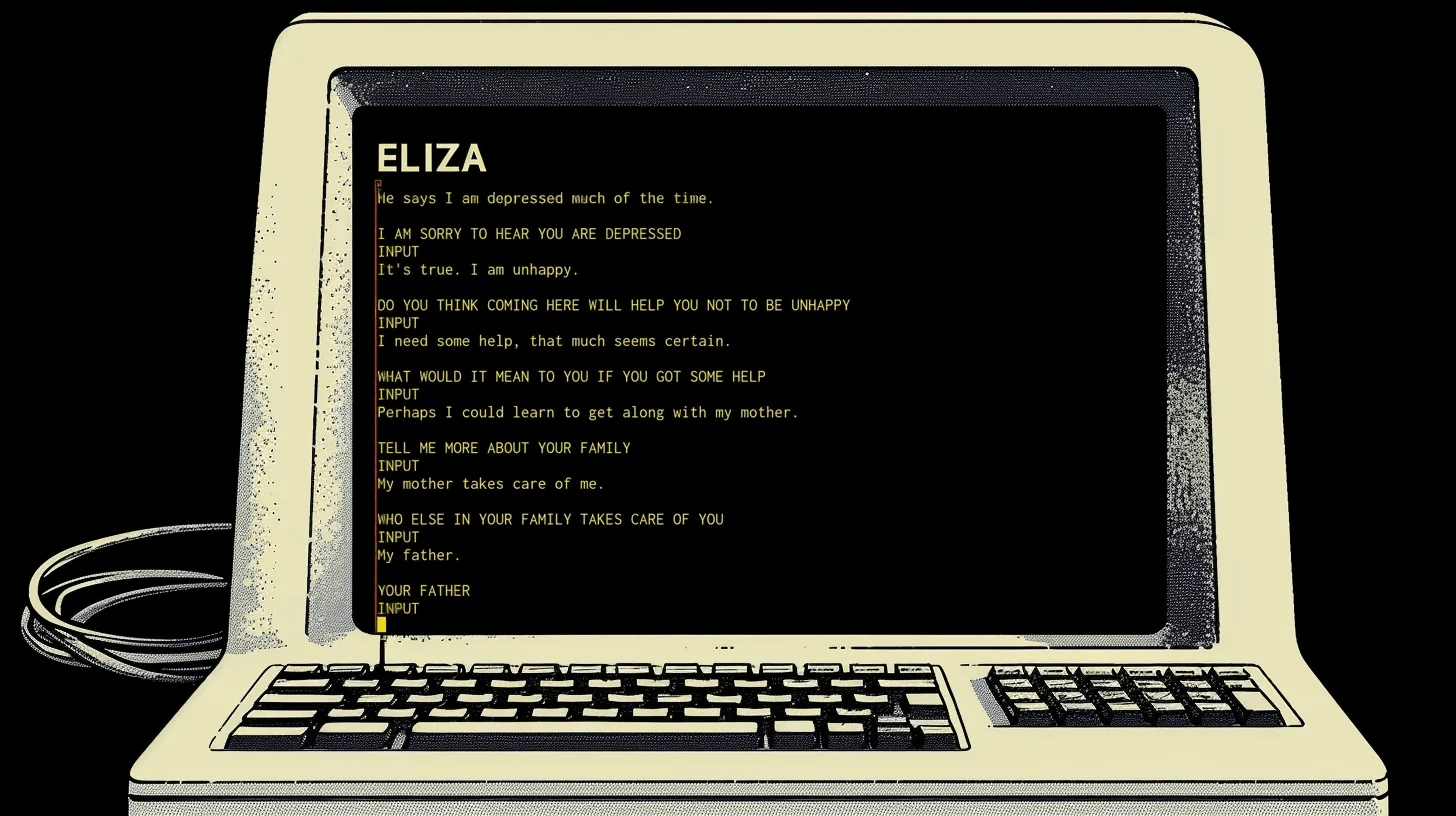

1966: Primer Chatbot ELIZA

El MIT crea ELIZA, el primer programa que simula una conversación humana. Usaba reglas muy simples, pero imagina lo impactante que fue en su momento ver una máquina que respondía como si fuera una psicóloga. Fue un parte aguas en la exploración del lenguaje natural, aunque claramente aún estaba muy lejos de entender de verdad lo que decía.

1970–1980: Sistemas Expertos y Primeras Aplicaciones

Durante los años 70 y 80, la IA vivió un auge gracias a los sistemas expertos: programas diseñados para imitar la toma de decisiones de un ser humano experto en un campo específico.

En vez de aprender por sí mismos (como hace la IA actual), estos sistemas usaban reglas “si sucede esto, haz esto otro”, basadas en el conocimiento que les daban humanos especializados. El objetivo era capturar la experiencia de médicos, ingenieros o científicos y convertirla en lógica computacional.

Estos sistemas funcionaban bastante bien en contextos controlados, donde las variables eran claras y limitadas. Pero fuera de esos entornos se caían, y ahí empezaron los problemas.

1973-1980: El Primer Invierno de la IA

Después del entusiasmo inicial en los 60 y principios de los 70, el campo de la IA sufrió su primera gran desilusión.

¿Por qué ocurrió?

-

Los algoritmos eran muy limitados: los sistemas no podían resolver problemas del mundo real.

-

El hardware no era lo suficientemente rápido ni barato.

-

Los resultados no cumplían con las expectativas exageradas que se habían creado.

-

El informe Lighthill (1973), publicado en el Reino Unido, criticó duramente el progreso de la IA y llevó a recortes de presupuesto en universidades británicas.

Resultado: el financiamiento cayó, muchos proyectos se cancelaron y el campo quedó casi estancado. Esa fue la primera ola de frío.

1987-1993: Segundo Invierno de la IA

A pesar del entusiasmo que trajo la ola de los sistemas expertos, (como MYCIN, XCON, etc.), la industria volvió a apostar fuerte por la IA. Pero… otra vez se fue abajo.

¿Qué pasó esta vez?

-

Los sistemas expertos tenían muchas limitaciones: no eran flexibles, no aprendían, y requerían mantenimiento constante.

-

El mercado de las “workstations de IA” colapsó cuando las computadoras personales se volvieron más potentes y baratas.

-

La burbuja de promesas no cumplidas explotó, y muchas empresas perdieron la fe en la IA.

Esta segunda congelada fue más dura en la industria que en la academia. Y aunque la investigación continuó, el entusiasmo general desapareció hasta mediados de los 90.

1993-2006: Renacimiento Silencioso

Después del segundo invierno, muchos pensaban que la IA iba a quedarse como una curiosidad académica. Pero en laboratorios, universidades y centros de investigación, la llama nunca se apagó, solo cambió de forma.

Durante estos años, la IA evolucionó de la mano del aprendizaje estadístico y las redes neuronales artificiales. No eran nuevas, pero con mejores datos y más capacidad de cómputo, empezaron a dar resultados más prometedores.

Un hito muy importante fue en 1997, cuando Deep Blue, la supercomputadora de IBM le ganó al campeón mundial de ajedrez Kasparov y por primera vez, el hombre fue derrotado por una máquina. Aunque Deep Blue no era “inteligente” en el sentido moderno, demostró el potencial del cómputo masivo + programación especializada.

2006-2015: Explosión del Deep Learning

Aquí es donde la IA comenzó a volverse lo que hoy conocemos.

En 2006, Geoffrey Hinton y su equipo reactivaron las redes neuronales profundas (deep neural networks), demostrando que con grandes cantidades de datos y GPUs, las redes profundas podían aprender representaciones muy potentes.

Momentos clave:

-

2012 Imagenet y AlexNet: un modelo de red neuronal profunda rompió récords de precisión en clasificación de imágenes. Fue el parteaguas: las grandes empresas tecnológicas comenzaron a apostar fuerte por el deep learning.

-

Google, Facebook, Amazon, Microsoft y Baidu empezaron a armar equipos dedicados a inteligencia artificial.

-

El reconocimiento de voz, la visión computarizada, los traductores automáticos y la predicción de texto empezaron a mejorar drásticamente.

Ya no solo era teoría: la IA empezaba a cambiar productos reales y a aparecer en nuestras vidas cotidianas. Desde los filtros de spam hasta Siri, la IA se volvió invisible, pero omnipresente.

2016-Presente: IA Moderna

La etapa más reciente ha sido un torbellino.

En 2017, Google presentó el paper “Attention Is All You Need”, donde introdujo los transformers: una arquitectura que revolucionó el procesamiento del lenguaje. A partir de ahí, todo explotó.

-

2018 Aparece BERT (Google): mejoró radicalmente las búsquedas al entender el contexto completo de una frase.

-

2019-2020 GPT-2 y GPT-3: modelos generativos de OpenAI capaces de escribir ensayos, crear código y mantener conversaciones coherentes.

-

2022 ChatGPT se lanza al público, y el mundo entra en una nueva era. Millones de usuarios comenzaron a experimentar con una IA capaz de explicar, resumir, traducir, bromear y más.

-

2023-2024 Modelos multimodales: como GPT-4, que entienden texto, imágenes, código, y pueden razonar con múltiples tipos de información al mismo tiempo.

Y en paralelo, otras ramas como la visión computacional, los modelos generativos de imágenes (Midjourney, DALL·E), la IA en medicina, automatización industrial, autos autónomos, y más, comenzaron a desarrollarse a una velocidad impresionante.

¿Y ahora qué?

La historia de la Inteligencia Artificial está lejos de terminar. De hecho, estamos justo en el punto donde esta tecnología está dejando de ser exclusiva de grandes laboratorios y se está volviendo accesible para empresas de todos los tamaños.

Y ahí es donde nosotros entramos, porque además de entender esta historia, queremos ayudarte a aprovechar esta tecnología desde ya, con soluciones hechas a la medida de tu negocio.

En Inmersys, desarrollamos soluciones de IA personalizadas para empresas que quieren innovar sin complicarse. Ya sea que estés explorando ideas o quieras llevar un proyecto a producción, podemos ayudarte a darle forma y convertirlo en realidad.

¿Listo para comenzar tu propio capítulo en la historia de la IA?

Escríbenos y veamos juntos cómo aplicar esta tecnología a tu negocio 🚀

.png)

ES

ES

EN

EN